在實際生活中,我們通常不會期望一個圖像在經(jīng)過縮小后變成另外一個模樣完全不同的圖像,但這樣奇怪的事情可能會在人工智能領(lǐng)域發(fā)生。

來自德國 技術(shù)大學(xué)的研究人員通過大量實驗已經(jīng)證明,仔細(xì)修改數(shù)碼照片的像素值可以使照片在縮小尺寸后變成與之前完全不同的圖像,而這些對圖像的修改操作在人工智能算法領(lǐng)域的影響值得被廣泛關(guān)注。

圖像縮放技術(shù)在人工智能研究領(lǐng)域有著十分重要的地位,但是也存在一些挑戰(zhàn)。其主要的問題就是,惡意攻擊者可以利用這種圖像縮放技術(shù),對用于人臉識別、目標(biāo)檢測等計算機視覺方向的機器學(xué)習(xí)模型發(fā)起對抗性攻擊。

其中,對抗性機器學(xué)習(xí)是一種對數(shù)據(jù)進(jìn)行操作的技術(shù),它能在不被人類察覺的情況下改變?nèi)斯ぶ悄芩惴ǖ男袨椋鴦?chuàng)建對抗性的機器學(xué)習(xí)示例是一個反復(fù)試驗的過程。創(chuàng)建對抗性示例包括對圖像像素進(jìn)行細(xì)微的調(diào)整,再通過 AI 算法重新運行該圖像,以查看圖像置信度的變化。通過適當(dāng)調(diào)整后ai軟件中怎么輸入顏色的cmyk值?,可以自動化創(chuàng)建一個噪音映射(noise map)來降低一個類的置信度,而提高另一個類的置信度。

在今年 安全研討會上發(fā)表的一篇論文中,TU 的研究人員就針對機器學(xué)習(xí)系統(tǒng)的分級和防止對抗性圖像縮放攻擊進(jìn)行了深入的回顧。他們的發(fā)現(xiàn)不斷提醒我們,AI 算法許多隱藏的方面和威脅還未被發(fā)現(xiàn),導(dǎo)致這些影響在我們的日常生活中正變得越來越突出。

對抗性圖像縮放

當(dāng)在許多實例上訓(xùn)練時,機器學(xué)習(xí)模型創(chuàng)建不同類之間相似性程度的數(shù)學(xué)表達(dá)。例如,如果你訓(xùn)練一個機器學(xué)習(xí)算法來區(qū)分熊貓和長臂猿,它就會嘗試創(chuàng)建一個統(tǒng)計模型來區(qū)分新圖像中的像素是更像熊貓還是長臂猿。

實際上,這些人工智能算法學(xué)習(xí)區(qū)分不同物體的方式與人類視覺的工作方式不同。大多數(shù)對抗性攻擊利用這種差異,在改變機器學(xué)習(xí)系統(tǒng)輸出的同時,進(jìn)行人類肉眼無法察覺的細(xì)微調(diào)整。

例如,當(dāng)你讓一個人描述他是如何從圖片中發(fā)現(xiàn)熊貓的,他可能會尋找一些目標(biāo)的身體特征,比如眼睛周圍的黑色毛發(fā),黑白相間的皮毛以及體型大小。他可能還會給出其他的背景,比如他希望看到熊貓在什么樣的棲息地,會擺出什么樣的動作姿勢等等。

而對于人工神經(jīng)網(wǎng)絡(luò)來說,只要根據(jù)公式,通過計算機程序運行圖像的像素值提供正確的答案,就確信所看到的圖像確實是一只熊貓。換句話說,通過正確地調(diào)整圖像中的像素值,你也可以讓 AI 誤以為它看到的不是熊貓。

其中的細(xì)節(jié)在于,研究人員在圖像上添加了一層人眼幾乎覺察不到的噪聲。

當(dāng)新的像素值通過人工神經(jīng)網(wǎng)絡(luò)時,會產(chǎn)生從長臂猿的圖像中所期望的結(jié)果。而在人眼看來,左右兩幅圖像似乎是同一只熊貓。

研究人員在他們的論文中寫道:“盡管大量研究都在研究針對學(xué)習(xí)算法的攻擊,但目前為止,幾乎沒有人關(guān)注機器學(xué)習(xí)預(yù)處理中的漏洞。”但是,當(dāng)經(jīng)典的對抗性攻擊利用人工智能算法內(nèi)部工作的特性時,圖像縮放攻擊就集中在機器學(xué)習(xí)流水線的預(yù)處理階段。

圖像縮放攻擊

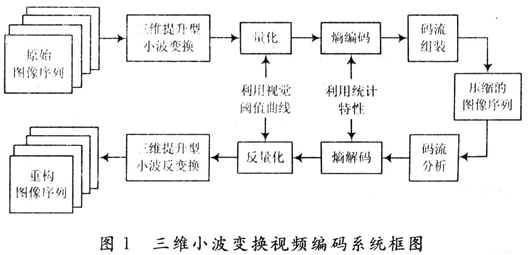

對于輸入數(shù)據(jù)來說,每一個應(yīng)用于圖像處理方向的機器學(xué)習(xí)算法都有一系列的要求。這些要求主要包括圖像的特定大小,但其他因素(如顏色通道的數(shù)量和顏色深度)也可能會被涉及到。

無論你是在訓(xùn)練一個機器學(xué)習(xí)模型,還是用該模型進(jìn)行推理(分類、目標(biāo)檢測等),都需要對輸入圖像進(jìn)行預(yù)處理以滿足 AI 的輸入要求。根據(jù)以上提及的所有需求,我們可以假定預(yù)處理過程通常需要將圖像縮放到合適的大小。并且,就像我們通常在軟件中遇到的情況一樣,當(dāng)黑客知道一個程序(或者至少是程序的一部分)工作過程的時候,他們會試圖找到方法修改程序來謀取私利。而這就是圖像縮放攻擊發(fā)揮作用的地方。

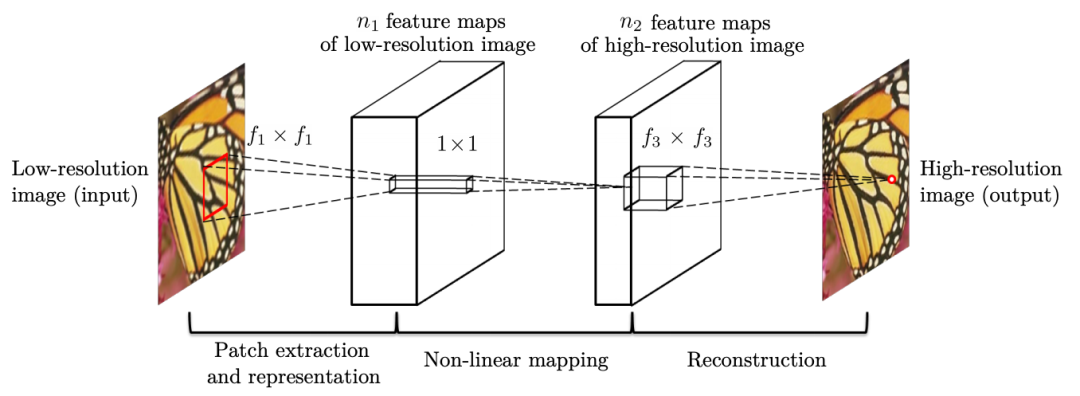

圖像縮放攻擊的關(guān)鍵思想是在預(yù)處理階段通過調(diào)整圖像像素大小來改變輸入圖像的外觀。事實上,機器學(xué)習(xí)和深度學(xué)習(xí)大多都使用一些眾所周知且有文檔記載的縮放算法。這些算法中的大多數(shù)(比如最近鄰插值和雙線性插值)都和 等用于圖像編輯的應(yīng)用程序使用的算法一樣,這使得攻擊者更容易設(shè)計出同時適用于多種機器學(xué)習(xí)算法的漏洞。

當(dāng)圖像被縮小時,進(jìn)行縮放后的圖像的每個像素都是源圖像中像素塊值的組合,其中執(zhí)行這種轉(zhuǎn)換的數(shù)學(xué)函數(shù)稱為“核函數(shù)”。然而,并不是源像素塊中的所有像素在核函數(shù)中的貢獻(xiàn)是相等的(如果相等會使得調(diào)整后的圖像會變得太模糊)。因此,在大多數(shù)算法中,核函數(shù)將更大的權(quán)重賦給更接近源像素塊中間的像素。

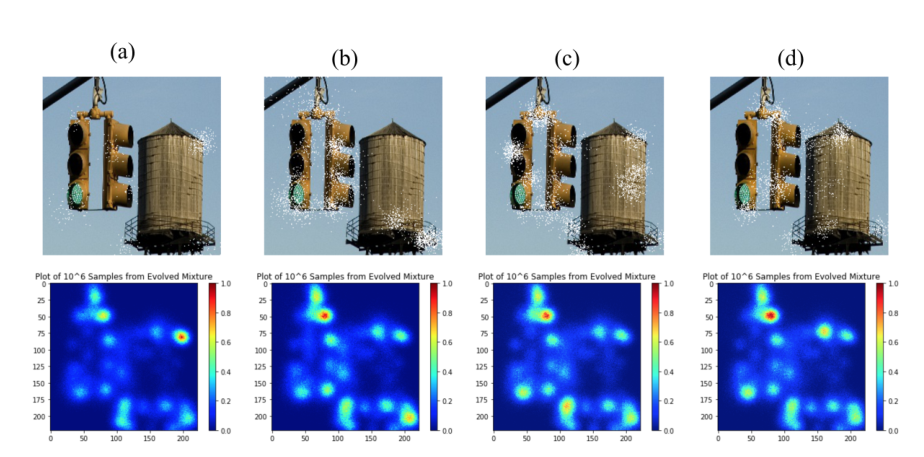

在對抗性預(yù)處理中,攻擊者獲取一幅圖像,并在正確的位置對像素值進(jìn)行適當(dāng)調(diào)整。當(dāng)圖像經(jīng)過縮放算法后,它會變成目標(biāo)圖像。最后ai軟件中怎么輸入顏色的cmyk值?,再用機器學(xué)習(xí)算法處理修改后的圖像。基本上,人眼看到的是源圖像,而機器學(xué)習(xí)模型看到的是目標(biāo)圖像。

當(dāng)攻擊一個機器學(xué)習(xí)模型時,攻擊者必須知道所使用的大小調(diào)整算法的類型和核函數(shù)的核大小。由于大多數(shù)機器學(xué)習(xí)庫中只有很少的縮放選項,因此研究人員通過實驗發(fā)現(xiàn)攻擊者只需嘗試幾次就能得到正確的參數(shù)設(shè)置。

在 的評論中,IBM 的首席科學(xué)家 Chen Pin-Yu 將圖像縮放與隱寫術(shù)()進(jìn)行了比較,后者將消息(這里是縮小后的圖像)嵌入源圖像中,只能采用縮小后的算法進(jìn)行解碼。

寫過幾篇關(guān)于對抗性機器學(xué)習(xí)論文的 Chen 說:“我很好奇這種攻擊是否也與圖像縮放算法無關(guān)。但基于通用攝動的成功,我認(rèn)為通用圖像縮放攻擊也是可行的。”

圖像縮放攻擊示例

對于機器學(xué)習(xí)算法方向的圖像縮放攻擊主要有兩種情況。其中一種攻擊類型是創(chuàng)建在經(jīng)過訓(xùn)練后的機器學(xué)習(xí)算法中產(chǎn)生錯誤預(yù)測的對抗性實例。但研究人員在他們的論文中指出,或許“數(shù)據(jù)中毒”攻擊才是圖像縮放的更大威脅。

而“數(shù)據(jù)中毒”是一種對抗性攻擊,在當(dāng)機器學(xué)習(xí)模型調(diào)整其參數(shù)到圖像的成千上萬像素這一訓(xùn)練階段時發(fā)生。如果攻擊者能夠訪問并篡改訓(xùn)練中使用的數(shù)據(jù)集,就能夠讓機器學(xué)習(xí)模型在對抗性示例上進(jìn)行訓(xùn)練。

示例一:

假設(shè)有一家公司正在開發(fā)一種面部識別系統(tǒng),以控制在處理敏感材料區(qū)域的訪問權(quán)限。為了做到這一點,該公司的工程師們正在訓(xùn)練一個卷積神經(jīng)網(wǎng)絡(luò)來檢測授權(quán)員工的臉部。

當(dāng)團(tuán)隊正在收集訓(xùn)練數(shù)據(jù)集時,一個有意破壞的員工偷偷地將一些篡改過的圖像隱藏在未經(jīng)授權(quán)的員工的面部照片中。在訓(xùn)練了神經(jīng)網(wǎng)絡(luò)之后,工程師們?yōu)榱舜_保系統(tǒng)能正確地檢測到被授權(quán)的員工,對其進(jìn)行測試。他們還會檢查一些隨機圖像,以確保 AI 算法不會將訪問權(quán)限錯誤地授予給非授權(quán)人員。

但這就存在一個問題,只有他們明確地檢查對抗性攻擊中被攻擊者臉部的機器學(xué)習(xí)模型,他們才會發(fā)現(xiàn)被惡意篡改的數(shù)據(jù)。

示例二:

假設(shè)你正在訓(xùn)練一個神經(jīng)網(wǎng)絡(luò)來識別停車標(biāo)志的圖像,以便以后在自動駕駛汽車時使用。

惡意攻擊者可以破壞訓(xùn)練數(shù)據(jù),使其包含經(jīng)過修補的停車標(biāo)志圖像,這些圖像被稱為“對抗性補丁”。經(jīng)過訓(xùn)練后,神經(jīng)網(wǎng)絡(luò)把該補丁上的所有標(biāo)志與目標(biāo)聯(lián)系起來。

這樣會導(dǎo)致自動駕駛汽車把一些隨機的標(biāo)志當(dāng)作停車標(biāo)志,或者更糟的是,進(jìn)行錯誤分類并繞過真正的停車標(biāo)志。

保護(hù)機器學(xué)習(xí)模型

TU 的研究人員在其論文中強調(diào),因為大多數(shù)機器學(xué)習(xí)模型使用的是少數(shù)流行的圖像縮放算法之一,所以圖像縮放攻擊對 AI 來說是一個特別嚴(yán)重的威脅。

這使得圖像縮放攻擊“與模型無關(guān)”,意思就是它們對目標(biāo)人工智能算法類型不敏感,而單一的攻擊方案可以應(yīng)用于整個范圍的機器學(xué)習(xí)算法。相比之下,經(jīng)典的對抗性例子是為每種機器學(xué)習(xí)模型設(shè)計的,如果目標(biāo)模型發(fā)生輕微變化,攻擊極有可能不再有效。

Chen 在論文中說道:“與白盒對抗性攻擊相比,圖像縮放攻擊需要更少的信息(只需要知道目標(biāo)系統(tǒng)使用了何種縮放算法),所以從攻擊者的角度來看,它是一種更實用的攻擊。”“然而,它仍然沒有不需要目標(biāo)機器學(xué)習(xí)模型信息的黑盒對抗性攻擊實用。”其中,黑盒對抗性攻擊是一種通過觀察機器學(xué)習(xí)模型的輸出值來產(chǎn)生對抗性擾動的高級技術(shù)。

Chen 接著在文章中承認(rèn),圖像縮放攻擊確實是一種生成對抗性實例的有效方法。但他補充道,縮放操作并不是都出現(xiàn)在每個機器學(xué)習(xí)系統(tǒng)中。他說:“圖像縮放攻擊僅限于基于圖像且具有縮放操作的模型,但是在沒有縮放操作和其他數(shù)據(jù)模式的圖像模型中也可能存在對抗性實例。”對抗性機器學(xué)習(xí)也適用于音頻和文本數(shù)據(jù)。

從積極的角度來看,對抗性圖像縮放的單一性使得更好地檢查攻擊和開發(fā)保護(hù)機器學(xué)習(xí)系統(tǒng)的新技術(shù)成為可能。

TU 的研究人員在文中寫道:“由于機器學(xué)習(xí)模型的復(fù)雜性,針對學(xué)習(xí)算法的攻擊仍然難以分析,但定義堅挺的縮放算法結(jié)構(gòu)使得我們能更全面地分析縮放攻擊并開發(fā)有效的防御技術(shù)。”在他們的論文中,研究人員提供了幾種阻撓對抗性圖像縮放攻擊的方法,包括平滑核函數(shù)的權(quán)重縮放算法以及可以消除篡改像素值影響的圖像重建過濾器。

“我們的工作為機器學(xué)習(xí)中預(yù)處理的安全性提供了新的見解,”研究人員寫道。“我們相信,有必要進(jìn)行深入的研究工作,從而確定和排除數(shù)據(jù)處理不同階段的漏洞,同時加強以學(xué)習(xí)為基礎(chǔ)的系統(tǒng)的安全性能。”讓機器學(xué)習(xí)算法對對抗性攻擊具有魯棒性已成為近年來一個較為活躍的研究領(lǐng)域。對抗性實例除了用于攻擊之外也被用于模型訓(xùn)練,以增強模型的健壯性。因此,為了進(jìn)行對抗性模型訓(xùn)練,不同類型的對抗性攻擊實施是有益的。

編譯:馮雪璐

排版:趙辰霞

編審:王新凱

參考文獻(xiàn):