2.2網(wǎng)頁基礎87

2.3爬蟲的基本原理93

2.4會話和

2.5代理的基本原理99

第3章基本庫的使用102

3.1使用

3.2使用

3.4抓取貓眼電影排行150

第4章解析庫的使用158

4.1使用

4.2使用

4.3使用

第5章數(shù)據(jù)存儲197

5.1文件存儲197

5.2關系型數(shù)據(jù)庫存儲207

5.3非關系型數(shù)據(jù)庫存儲213

第6章Ajax數(shù)據(jù)爬取232

6.1什么是

6.2Ajax 分析方法234

6.3Ajax 結(jié)果提取238

6.4分析 Ajax 爬取今日頭條街拍美圖242

第7章動態(tài)渲染頁面爬取249

7. 的使用249

7. 的使用262

7. 負載均衡配置286

7.4使用 爬取淘寶商品289

第8章驗證碼的識別298

8.1圖形驗證碼的識別298

8.2極驗滑動驗證碼的識別301

8.3點觸驗證碼的識別311

8.4微博宮格驗證碼的識別318

第9章代理的使用326

9.1代理的設置326

9.2代理池的維護333

9.3付費代理的使用347

9.4ADSL 撥號代理351

9.5使用代理爬取微信公眾號文章364

第10章模擬登錄379

10.1模擬登錄并爬取

10. 池的搭建385

第11章App 的爬取398

11. 的使用398

11. 的使用405

11. 爬取“得到”App電子書信息417

11. 的基本使用423

11. 爬取微信朋友圈433

11.+ 爬取京東商品437

第12章 框架的使用443

12. 框架介紹443

12. 的基本使用445

12. 用法詳解459

第13章 框架的使用468

13. 框架介紹468

13. 入門470

13. 的用法480

13. 的用法486

13. 的用法487

13. 的用法494

13.7Item 的用法496

13. 對接

13. 對接

13. 通用爬蟲516

13.11 的使用533

13. 對接

13. 爬取新浪微博541

第14章分布式爬蟲555

14.1分布式爬蟲原理555

14.-Redis 源碼解析558

14. 分布式實現(xiàn)564

14. 的對接569

第15章分布式爬蟲的部署577

15. 分布式部署577

15.- 的使用582

這 15 章的內(nèi)容,文字簡單歸納如下。

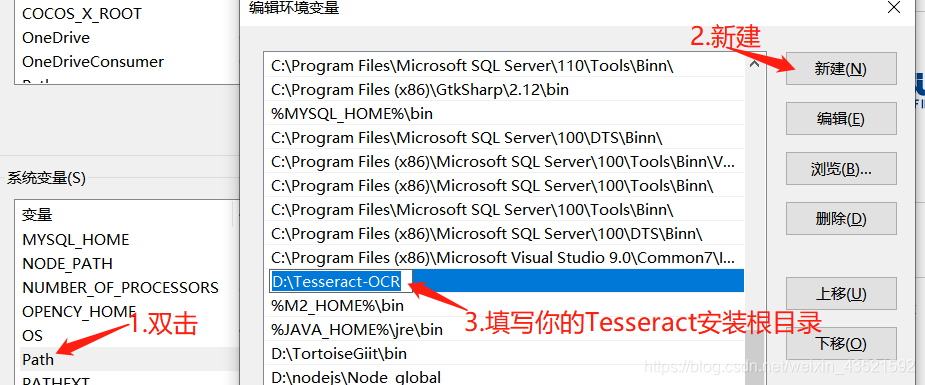

第 1 章介紹了本書所涉及的所有環(huán)境的配置詳細流程,兼顧 、Linux、Mac 三大平臺。本章不用逐節(jié)閱讀,需要的時候查閱即可。

第 2 章介紹了學習爬蟲之前需要了解的基礎知識,如 HTTP、爬蟲、代理的基本原理、網(wǎng)頁基本結(jié)構(gòu)等內(nèi)容,對爬蟲沒有任何了解的讀者建議好好了解這一章的知識。

第 3 章介紹了最基本的爬蟲操作,一般學習爬蟲都是從這一步學起的。這一章介紹了最基本的兩個請求庫(和)和正則表達式的基本用法。學會了這一章,就可以掌握最基本的爬蟲技術(shù)了。

第 4 章介紹了頁解析庫的基本用法,包括 Soup、XPath、 的基本使用方法,它們可以使得信息的提取更加方便、快捷,是爬蟲必備利器。

第 5 章介紹了數(shù)據(jù)存儲的常見形式及存儲操作,包括 TXT、JSON、CSV 各種文件的存儲,以及關系型數(shù)據(jù)庫MySQL和非關系型數(shù)據(jù)庫、Redis 存儲的基本存儲操作。學會了這些內(nèi)容,我們可以靈活方便地保存爬取下來的數(shù)據(jù)。

第 6 章介紹了 Ajax 數(shù)據(jù)爬取的過程,一些網(wǎng)頁的數(shù)據(jù)可能是通過Ajax請求API接口的方式加載的,用常規(guī)方法無法爬取,本章介紹了使用Ajax進行數(shù)據(jù)爬取的方法。

第 7 章介紹了動態(tài)渲染頁面的爬取,現(xiàn)在越來越多的網(wǎng)站內(nèi)容是經(jīng)過 渲染得到的,而原始HTML文本可能不包含任何有效內(nèi)容,而且渲染過程可能涉及某些加密算法,可以使用 、 等工具來實現(xiàn)模擬瀏覽器進行數(shù)據(jù)爬取的方法。

第 8 章介紹了驗證碼的相關處理方法。驗證碼是網(wǎng)站反爬蟲的重要措施,我們可以通過本章了解到各類驗證碼的應對方案,包括圖形驗證碼、極驗驗證碼、點觸驗證碼、微博宮格驗證碼的識別。

第 9 章介紹了代理的使用方法,限制 IP 的訪問也是網(wǎng)站反爬蟲的重要措施。另外,我們也可以使用代理來偽裝爬蟲的真實IP,使用代理可以有效解決這個問題。通過本章,我們了解到代理的使用方法,還學習了代理池的維護方法,以及 ADSL 撥號代理的使用方法。

第 10 章介紹了模擬登錄爬取的方法,某些網(wǎng)站需要登錄才可以看到需要的內(nèi)容python爬取app數(shù)據(jù)庫,這時就需要用爬蟲模擬登錄網(wǎng)站再進行爬取了。本章介紹了最基本的模擬登錄方法以及維護一個 池的方法。

第 11 章介紹了App的爬取方法,包括基本的 、 抓包軟件的使用。此外,還介紹了 對接 腳本進行實時抓取的方法python爬取app數(shù)據(jù)庫,以及使用 完全模擬手機 App 的操作進行爬取的方法。

第 12 章介紹了 爬蟲框架及用法,該框架簡潔易用、功能強大,可以節(jié)省大量開發(fā)爬蟲的時間。本章結(jié)合案例介紹了使用該框架進行爬蟲開發(fā)的方法。

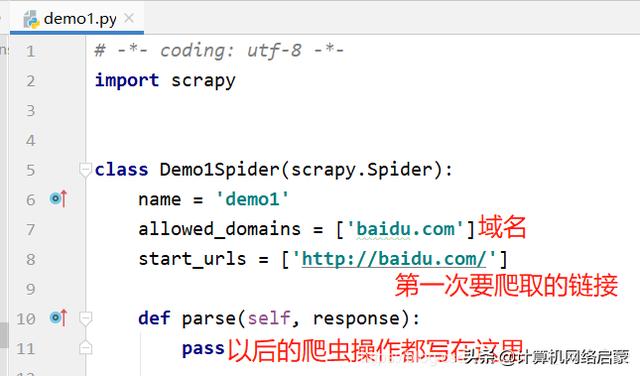

第 13 章介紹了 爬蟲框架及用法。 是目前使用最廣泛的爬蟲框架,本章介紹了它的基本架構(gòu)、原理及各個組件的使用方法,另外還介紹了 通用化配置、對接 的一些方法。

第 14 章介紹了分布式爬蟲的基本原理及實現(xiàn)方法。為了提高爬取效率,分布式爬蟲是必不可少的,本章介紹了使用 和 Redis 實現(xiàn)分布式爬蟲的方法。

第 15 章介紹了分布式爬蟲的部署及管理方法。方便快速地完成爬蟲的分布式部署,可以節(jié)省開發(fā)者大量的時間。本章結(jié)合 、、、 等工具介紹了分布式爬蟲部署和管理的實現(xiàn)。